来源: C# 任务队列还在轮询?300%性能提升的智能调度方案来了!

前言

后端系统开发中,异步任务处理几乎是绕不开的环节。然而,传统的ConcurrentQueue<T> + 轮询方案存在诸多弊端,如CPU空转严重、内存占用高、响应延迟大等,严重影响系统性能。

对于.NET开发而言,实现一个高效的任务处理机制至关重要,它能让系统性能得到显著提升。本文将介绍如何用C#完成一个真正高效的任务处理器,告别性能瓶颈。

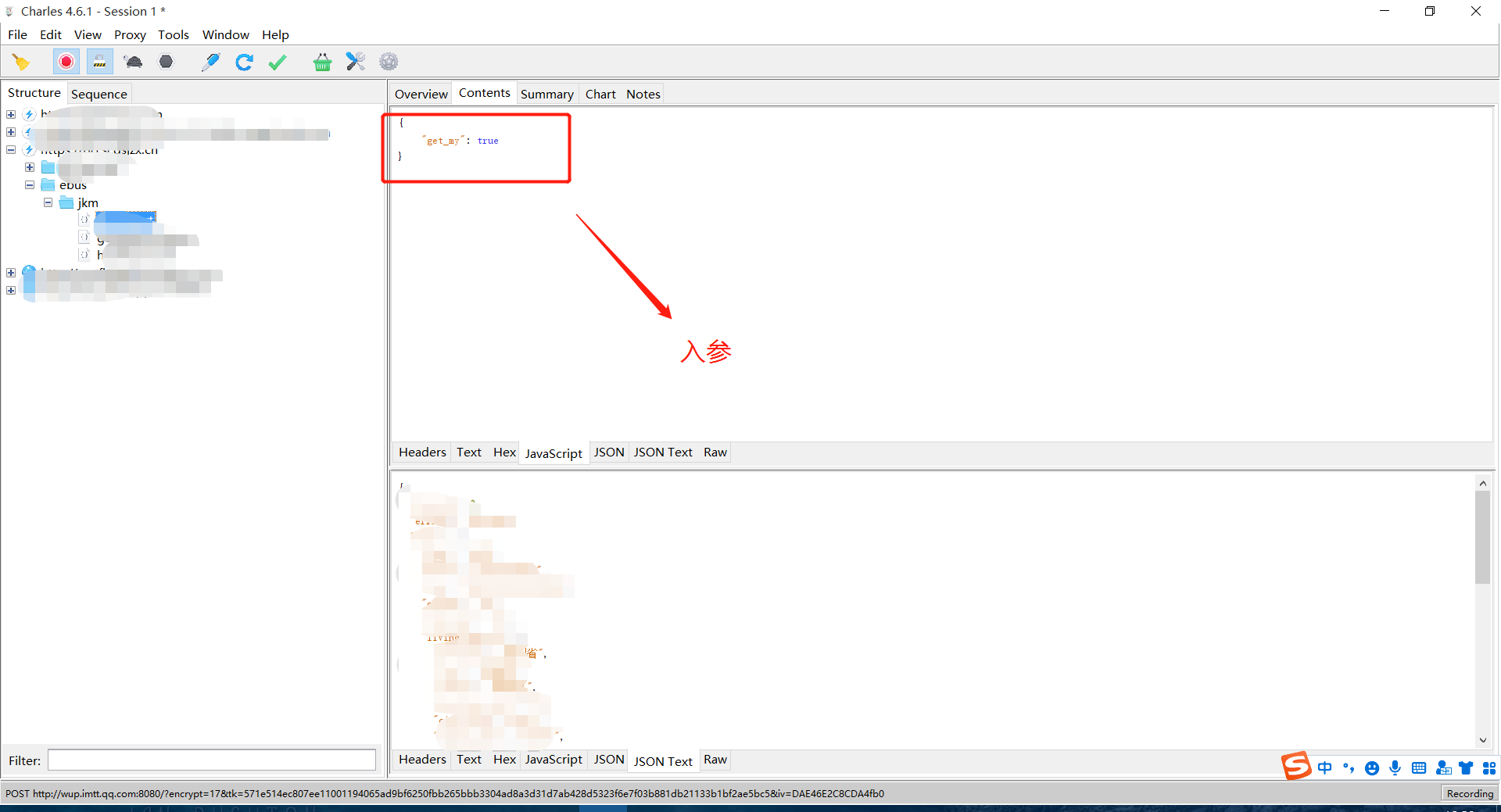

系统效果

传统方案的三大问题

问题一:CPU空转浪费

传统轮询方式如同不停转圈的陀螺,即便没有任务,也会不断检查队列状态,造成CPU资源的严重浪费。

问题二:响应延迟

100ms的轮询间隔在高并发场景下,延迟会被无限放大,直接影响用户体验。

问题三:扩展性差

单线程处理限制了并发能力,面对突发流量,系统极易成为性能瓶颈。

解决方案

WinForm可视化任务处理器

为解决上述问题,我们将构建一个完整的WinForm任务处理器,其核心设计思路如下:

-

可视化监控:实时呈现队列状态、处理进度、CPU使用率,让开发者对系统运行情况一目了然。

-

异常处理:模拟真实场景的错误恢复机制,增强系统的稳定性和可靠性。

-

优雅停机:确保任务处理的安全性,避免因突然停止导致的任务丢失或数据损坏。

代码实现

主窗体实现

主窗体代码负责处理用户交互和界面更新,通过事件绑定与任务处理器进行通信。

例如,在启动按钮点击事件中,启动任务处理器并更新日志信息;

在添加任务按钮点击事件中,创建新任务并加入队列。

以下是部分关键代码:

namespace AppTaskProcessorDemo

{

publicpartialclassForm1 : Form

{

privatereadonly TraditionalTaskProcessor _taskProcessor;

privatereadonly System.Windows.Forms.Timer _uiTimer;

privateint _taskCounter = 1;

public Form1()

{

InitializeComponent();

_taskProcessor = new TraditionalTaskProcessor();

// 定时器用于更新UI显示

_uiTimer = new System.Windows.Forms.Timer();

_uiTimer.Interval = 100;

_uiTimer.Tick += UpdateUI;

_uiTimer.Start();

// 绑定事件

_taskProcessor.TaskProcessed += OnTaskProcessed;

_taskProcessor.ProcessorStatusChanged += OnProcessorStatusChanged;

_taskProcessor.ErrorOccurred += OnErrorOccurred;

}

private void btnStart_Click(object sender, EventArgs e)

{

btnStart.Enabled = false;

btnStop.Enabled = true;

btnAddTask.Enabled = true;

_ = _taskProcessor.StartProcessing();

LogMessage("任务处理器已启动");

}

private void btnStop_Click(object sender, EventArgs e)

{

_taskProcessor.Stop();

btnStart.Enabled = true;

btnStop.Enabled = false;

btnAddTask.Enabled = false;

LogMessage("任务处理器已停止");

}

private void btnAddTask_Click(object sender, EventArgs e)

{

var taskItem = new TaskItem

{

Id = _taskCounter++,

Name = $"任务-{_taskCounter - 1}",

Data = $"这是第{_taskCounter - 1}个任务的数据",

CreatedTime = DateTime.Now

};

_taskProcessor.EnqueueTask(taskItem);

LogMessage($"已添加任务: {taskItem.Name}");

}

private void btnClear_Click(object sender, EventArgs e)

{

txtLog.Clear();

}

private void OnTaskProcessed(object sender, TaskProcessedEventArgs e)

{

if (InvokeRequired)

{

Invoke(new Action(() => OnTaskProcessed(sender, e)));

return;

}

LogMessage($"✅ 任务完成: {e.Task.Name} (耗时: {e.ProcessTime}ms)");

}

private void OnProcessorStatusChanged(object sender, ProcessorStatusEventArgs e)

{

if (InvokeRequired)

{

Invoke(new Action(() => OnProcessorStatusChanged(sender, e)));

return;

}

lblStatusValue.Text = e.IsRunning ? "运行中" : "已停止";

lblStatusValue.ForeColor = e.IsRunning ? System.Drawing.Color.Green : System.Drawing.Color.Red;

}

private void OnErrorOccurred(object sender, TaskErrorEventArgs e)

{

if (InvokeRequired)

{

Invoke(new Action(() => OnErrorOccurred(sender, e)));

return;

}

LogMessage($"❌ 错误: 任务 {e.Task.Name} - {e.Exception.Message}");

}

private void UpdateUI(object sender, EventArgs e)

{

lblQueueCountValue.Text = _taskProcessor.QueueCount.ToString();

lblProcessedCountValue.Text = _taskProcessor.ProcessedCount.ToString();

lblErrorCountValue.Text = _taskProcessor.ErrorCount.ToString();

// 更新CPU使用率(模拟)

lblCpuUsageValue.Text = $"{_taskProcessor.CpuUsagePercentage:F1}%";

}

private void LogMessage(string message)

{

if (InvokeRequired)

{

Invoke(new Action(() => LogMessage(message)));

return;

}

string logEntry = $"[{DateTime.Now:HH:mm:ss}] {message}";

txtLog.AppendText(logEntry + Environment.NewLine);

txtLog.SelectionStart = txtLog.Text.Length;

txtLog.ScrollToCaret();

}

protected override void OnFormClosing(FormClosingEventArgs e)

{

_taskProcessor?.Stop();

_uiTimer?.Stop();

base.OnFormClosing(e);

}

}

}

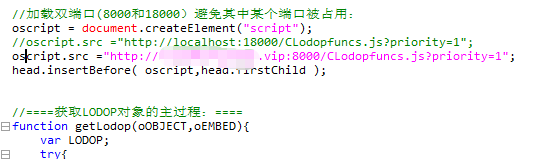

核心处理器实现

核心处理器负责任务的获取、处理和状态管理。它使用ConcurrentQueue<TaskItem>存储任务,通过循环检查队列状态来处理任务,并在处理过程中处理异常和更新任务计数。

以下是部分关键代码:

public classTraditionalTaskProcessor

{

privatereadonly ConcurrentQueue<TaskItem> _queue = new();

privatereadonly CancellationTokenSource _cts = new();

privatevolatilebool _isRunning = false;

privateint _processedCount = 0;

privateint _errorCount = 0;

public async Task StartProcessing()

{

if (_isRunning) return;

_isRunning = true;

OnProcessorStatusChanged(true);

await Task.Run(async () =>

{

while (_isRunning && !_cts.Token.IsCancellationRequested)

{

if (_queue.TryDequeue(outvar task))

{

try

{

var sw = Stopwatch.StartNew();

await ProcessTask(task);

sw.Stop();

Interlocked.Increment(ref _processedCount);

OnTaskProcessed(task, sw.ElapsedMilliseconds);

}

catch (Exception ex)

{

Interlocked.Increment(ref _errorCount);

OnErrorOccurred(task, ex);

}

}

else

{

// ⚠️ 关键问题:CPU空转

await Task.Delay(100, _cts.Token);

}

}

}, _cts.Token);

}

private async Task ProcessTask(TaskItem task)

{

// 模拟不同复杂度的任务处理

var processingTime = new Random().Next(500, 2000);

await Task.Delay(processingTime);

// 模拟偶发异常

if (new Random().Next(1, 20) == 1)

{

thrownew InvalidOperationException($"任务 {task.Name} 处理失败");

}

}

}

UI设计器

UI设计器代码定义了窗体的布局和控件属性,包括控制面板、状态监控面板和日志面板等。

通过设置控件的属性,如文本框的背景色、字体等,提升了界面的美观性和可读性。

应用场景

1、数据处理场景

日志分析系统:处理海量日志文件,通过异步任务处理器提高处理效率,减少系统响应时间。

报表生成:异步生成复杂统计报表,避免阻塞主线程,提升用户体验。

数据同步:定时同步不同系统间的数据,确保数据的一致性和及时性。

2、通知系统场景

邮件队列:批量发送营销邮件,通过任务处理器控制发送速度,避免邮件服务器压力过大。

消息推送:移动端消息推送队列,确保消息能够及时、准确地推送给用户。

短信服务:验证码和通知短信发送,提高短信发送的可靠性和效率。

常见问题

问题1:UI线程安全

在更新UI时,若直接跨线程操作UI控件,会引发异常。正确的做法是使用Invoke方法将操作委托给UI线程执行,确保线程安全。

例如:

// ❌ 错误做法

private void OnTaskProcessed(TaskProcessedEventArgs e)

{

txtLog.AppendText($"任务完成: {e.Task.Name}"); // 跨线程操作异常

}

// ✅ 正确做法

private void OnTaskProcessed(TaskProcessedEventArgs e)

{

if (InvokeRequired)

{

Invoke(new Action(() => OnTaskProcessed(e)));

return;

}

txtLog.AppendText($"任务完成: {e.Task.Name}");

}

问题2:资源释放

在窗体关闭时,应确保任务处理器停止运行,定时器停止工作,避免资源泄漏。

例如:

protected override void OnFormClosing(FormClosingEventArgs e)

{

_taskProcessor?.Stop(); // 确保优雅停机

_uiTimer?.Stop(); // 停止定时器

base.OnFormClosing(e);

}

问题3:异常处理

在处理任务时,应区分不同类型的异常,对正常取消操作不记录为错误,对真实业务异常进行详细记录。

例如:

// ✅ 完善的异常处理

try

{

await ProcessTask(task);

}

catch (OperationCanceledException)

{

// 正常取消操作,不记录为错误

return;

}

catch (Exception ex)

{

// 记录真实业务异常

LogError(ex, task);

}

性能测试数据

经过实际测试,传统轮询方案与优化后方案在各项指标上存在显著差异:

说明

“好的架构不是设计出来的,而是演进出来的”:从轮询到事件驱动,每一步优化都是为了更好的用户体验。

“性能优化的本质是资源的合理分配”:CPU不应该浪费在无意义的空转上。

“可视化是调试的最佳伙伴”:眼见为实的监控面板让问题无所遁形。

高级进阶方向

Channel模式:探索.NET 中的高性能队列解决方案,进一步提升任务处理效率。

Producer – Consumer模式:研究更高效的生产者消费者实现,优化任务的生产和消费流程。

背压机制:引入背压机制,防止队列溢出,确保系统的稳定性。

分布式队列:集成Redis、RabbitMQ等中间件,实现分布式任务队列,处理大规模任务。

总结

通过这个实战项目,我们直观地看到了传统任务队列方案的局限性。可视化的监控界面让我们能够实时观察系统的运行状态,为性能调优和问题排查提供支持。

回顾三个核心要点:

传统轮询方案存在CPU空转、响应延迟、扩展性差的问题。

这只是任务队列优化之旅的第一步。在后续文章中,我们将为大家带来更高效的Channel模式和分布式队列解决方案,帮助大家开发更强大的系统。

Mikel

Mikel